Orquestación de Contenedores: Kubernetes y Docker, la Columna Vertebral de la Infraestructura Moderna

En el vertiginoso mundo del desarrollo de software actual, la agilidad, la escalabilidad y la fiabilidad son imperativos. Las aplicaciones ya no son monolitos estáticos, sino complejos sistemas distribuidos que necesitan ser gestionados de manera eficiente. Aquí es donde entran en juego los contenedores y, más importante aún, su orquestación.

En este artículo, desglosaremos dos de los pilares más importantes de esta revolución tecnológica: Docker y Kubernetes. Comprenderemos no solo qué son, sino por qué se han vuelto indispensables para cualquier equipo de desarrollo y operaciones que busque construir y mantener arquitecturas robustas y escalables.

¿Qué es la Orquestación de Contenedores?

Para entender la orquestación, primero debemos comprender qué es un contenedor. Imagina un contenedor de envío real: es una unidad estandarizada que puede empacar cualquier tipo de carga y transportarla a cualquier parte del mundo de manera consistente. En el software, un contenedor es una unidad de software estandarizada que empaqueta todo el código de una aplicación, sus bibliotecas, dependencias y configuraciones, para que pueda ejecutarse de manera confiable y consistente en cualquier entorno, desde tu máquina de desarrollo hasta la nube.

Ahora, cuando tienes no solo uno, sino cientos o miles de estos contenedores funcionando, ¿cómo los gestionas? ¿Cómo te aseguras de que se inician, se detienen, se escalan, se comunican entre sí y se recuperan de fallos? Ahí es donde entra la Orquestación de Contenedores.

La orquestación de contenedores es la automatización de la implementación, escalado, gestión y redes de contenedores. Esencialmente, es el cerebro que coordina el comportamiento de tus contenedores a gran escala, permitiendo que las aplicaciones distribuidas funcionen de manera fluida y eficiente.

¿Por qué es Necesaria en el Desarrollo de Software Moderno?

La necesidad de la orquestación surge de los desafíos inherentes a las arquitecturas de microservicios y las aplicaciones nativas de la nube:

- Complejidad: Gestionar manualmente cientos de contenedores, cada uno con sus propias configuraciones y dependencias, es inviable.

- Escalabilidad: Las aplicaciones necesitan responder rápidamente a los picos de demanda. La orquestación permite escalar los contenedores automáticamente.

- Alta Disponibilidad: Un único punto de fallo es inaceptable. La orquestación asegura que si un contenedor o un servidor falla, la aplicación sigue funcionando.

- Despliegues Consistentes: Garantiza que el entorno de desarrollo sea idéntico al de pruebas y al de producción, eliminando los clásicos "en mi máquina funciona".

Ventajas Clave de la Orquestación de Contenedores:

- Escalabilidad Elástica: Puedes escalar tus aplicaciones horizontalmente (añadiendo más instancias de contenedores) o verticalmente (dando más recursos a un contenedor) de manera automática o manual, según la demanda.

- Alta Disponibilidad y Resiliencia: Si un contenedor o un nodo falla, la orquestación redistribuye automáticamente la carga de trabajo a otros nodos saludables, minimizando el tiempo de inactividad.

- Gestión de Recursos Optimizada: La orquestación asigna recursos (CPU, memoria) de manera eficiente a los contenedores, aprovechando al máximo la infraestructura disponible.

- Despliegues Consistentes y Rápidos: Al tener todas las dependencias empaquetadas, los despliegues son predecibles, rápidos y menos propensos a errores.

- Balanceo de Carga Integrado: Las herramientas de orquestación suelen incluir funcionalidades de balanceo de carga para distribuir el tráfico entre las instancias de los contenedores.

- Auto-reparación: Pueden detectar y reemplazar contenedores que no responden o están en un estado de error.

Docker: La Base de la Contenerización

Antes de sumergirnos en la orquestación, es fundamental entender la tecnología que hizo popular a los contenedores: Docker.

¿Qué es Docker?

Docker es una plataforma de código abierto que permite a los desarrolladores empaquetar aplicaciones y sus dependencias en contenedores ligeros y portátiles. Su principal innovación radica en la estandarización del formato del contenedor y las herramientas para crearlos y ejecutarlos.

Contenedores vs. Máquinas Virtuales: La Diferencia Fundamental

A menudo, la gente confunde los contenedores con las máquinas virtuales (VMs). Aunque ambos ofrecen aislamiento, lo hacen de manera diferente y con distintas implicaciones de rendimiento y eficiencia:

- Máquinas Virtuales (VMs):

- Cada VM incluye un sistema operativo completo (guest OS), que se ejecuta sobre un hipervisor (como VMware, VirtualBox, Hyper-V).

- Son pesadas, consumen muchos recursos (RAM, CPU) y tardan más en iniciarse.

- Ofrecen un aislamiento fuerte a nivel de hardware virtualizado.

- Ideal para ejecutar múltiples sistemas operativos en un solo hardware o para aplicaciones que requieren un aislamiento completo y un sistema operativo dedicado.

- Contenedores (Docker):

- Comparten el kernel del sistema operativo del host. No incluyen un sistema operativo completo dentro de cada contenedor.

- Son ligeros, consumen menos recursos y se inician en segundos.

- Ofrecen un aislamiento a nivel de proceso, utilizando características del kernel de Linux como

namespacesycgroups. - Ideal para empaquetar y ejecutar aplicaciones de manera eficiente, especialmente microservicios.

En resumen, las VMs virtualizan el hardware, mientras que los contenedores virtualizan el sistema operativo.

Componentes Clave de Docker:

- Dockerfile: Es un archivo de texto simple que contiene una serie de instrucciones para construir una imagen de Docker. Piensa en él como una "receta" para tu aplicación.

- Ejemplo de Dockerfile: Fragmento de código

- Imagen de Docker: Es una plantilla inmutable y de solo lectura que contiene el código de la aplicación, un tiempo de ejecución, bibliotecas, variables de entorno y archivos de configuración necesarios. Es el "molde" a partir del cual se crean los contenedores. Las imágenes son la base para la consistencia.

- Contenedor de Docker: Es una instancia ejecutable de una imagen de Docker. Cuando ejecutas una imagen, se convierte en un contenedor en ejecución. Puedes crear, iniciar, detener, mover y eliminar contenedores. Un contenedor es el entorno aislado donde tu aplicación se ejecuta.

- Docker Engine: Es el corazón de Docker. Consiste en:

- Docker Daemon (dockerd): Un proceso en segundo plano que gestiona los contenedores, imágenes, volúmenes y redes.

- Docker CLI (docker): La herramienta de línea de comandos que usas para interactuar con el Docker Daemon (ej.

docker build,docker run,docker ps). - Docker Hub: Es un registro de imágenes de Docker basado en la nube. Es el lugar donde puedes encontrar imágenes preexistentes (como imágenes base de sistemas operativos o lenguajes de programación) y también almacenar y compartir tus propias imágenes. Es el "GitHub" para imágenes de contenedores.

Casos de Uso y Beneficios de Docker:

- Desarrollo Consistente: Los desarrolladores pueden empaquetar su entorno con la aplicación, asegurando que "funciona en mi máquina" se traduzca a "funciona en todas partes".

- Entrega Rápida de Software: Permite a los equipos de DevOps crear pipelines de CI/CD eficientes, automatizando la construcción, prueba y despliegue de aplicaciones.

- Microservicios: Facilita la creación y gestión de arquitecturas de microservicios, donde cada servicio se ejecuta en su propio contenedor.

- Aislamiento: Ofrece un aislamiento seguro entre aplicaciones, incluso si se ejecutan en el mismo host.

- Portabilidad: Una imagen de Docker puede ejecutarse en cualquier sistema que tenga Docker instalado, ya sea una laptop, un servidor en la nube o un centro de datos local.

- Utilización Eficiente de Recursos: Al no necesitar un SO completo por aplicación, Docker optimiza el uso de CPU y RAM.

Recursos recomendados para Docker:

- Documentación oficial de Docker: docker.com (El mejor punto de partida para entender cada comando y concepto).

- Tutoriales de Docker para principiantes: https://www.docker.com/get-started/ (Guías prácticas para empezar a usar Docker).

- Docker Labs: https://github.com/docker/labs (Proyectos prácticos para aprender Docker).

Kubernetes: El Orquestador Definitivo

Una vez que tienes tus aplicaciones empaquetadas en contenedores Docker, la siguiente pregunta es: ¿cómo gestionas un clúster de cientos o miles de ellos en producción? Aquí es donde Kubernetes entra en escena.

¿Qué es Kubernetes? Origen y Propósito.

Kubernetes (K8s) es una plataforma de código abierto para la automatización del despliegue, escalado y gestión de aplicaciones en contenedores. Nació como un proyecto interno de Google (llamado Borg), donde Google gestionaba miles de millones de contenedores a la semana. En 2014, Google lo abrió como un proyecto de código abierto y lo donó a la Cloud Native Computing Foundation (CNCF), convirtiéndose rápidamente en el estándar de facto para la orquestación de contenedores.

El propósito principal de Kubernetes es abstraer la complejidad de la infraestructura subyacente y proporcionar una plataforma declarativa para gestionar las aplicaciones en contenedores. Esto significa que le dices a Kubernetes "quiero que mi aplicación tenga 3 réplicas siempre ejecutándose" y Kubernetes se encarga de lograr ese estado deseado, manejando fallos, escalado y actualizaciones por ti.

Arquitectura de Kubernetes: Master y Worker Nodes

Un clúster de Kubernetes se compone de un conjunto de máquinas (físicas o virtuales) que funcionan como un todo. Estas máquinas se dividen en dos roles principales:

- Master Node (Plano de Control):

- El "cerebro" del clúster. Gestiona el estado deseado de los componentes del clúster, programa las cargas de trabajo y coordina la comunicación. Un clúster de producción suele tener múltiples Master Nodes para alta disponibilidad.

- Componentes Clave del Master Node:kube-apiserver: Es el punto de entrada principal para el clúster. Todas las interacciones (kubectl, otros componentes) se realizan a través de esta API. Es la puerta de enlace para el control del clúster.

- kube-scheduler: Observa los nuevos Pods sin nodo asignado y selecciona un nodo para que se ejecuten, basándose en requisitos de recursos, políticas, afinidad, etc.

- kube-controller-manager: Ejecuta los controladores de Kubernetes (ej. Replication Controller, Endpoint Controller, Service Account & Token Controllers). Estos controladores monitorean el estado del clúster y realizan acciones para llevar el estado actual al estado deseado.

- etcd: Una base de datos distribuida de tipo clave-valor, coherente y de alta disponibilidad, que almacena toda la configuración del clúster y su estado actual. Es el "único origen de verdad" para Kubernetes.

- Worker Nodes (Nodos de Trabajo / Minions):

- Son las máquinas donde se ejecutan tus aplicaciones en contenedores. Cada Worker Node tiene los componentes necesarios para ejecutar los Pods y comunicarse con el Master Node.

- Componentes Clave del Worker Node:kubelet: Un agente que se ejecuta en cada nodo. Se comunica con el API Server y se asegura de que los contenedores definidos en los Pods se estén ejecutando y saludables.

- kube-proxy: Un proxy de red que mantiene las reglas de red en los nodos, permitiendo la comunicación entre los Pods y desde/hacia el exterior del clúster.

- Container Runtime: El software responsable de ejecutar los contenedores. Docker es el runtime más común, pero Kubernetes es compatible con otros como containerd o CRI-O.

Conceptos Fundamentales de Kubernetes:

Para interactuar con Kubernetes, necesitas entender su vocabulario. Estos son los bloques de construcción de tus aplicaciones en K8s:

- Pods: La unidad más pequeña y fundamental desplegable en Kubernetes. Un Pod representa una instancia de una aplicación y puede contener uno o más contenedores (aunque lo más común es uno). Los contenedores dentro de un mismo Pod comparten la misma red, almacenamiento y recursos.

- Deployments: Un controlador que gestiona el despliegue declarativo de Pods. Le dices a un Deployment cuántas réplicas de tu aplicación quieres y Kubernetes se asegura de mantener ese número. Los Deployments manejan las actualizaciones (rollouts) y los retrocesos (rollbacks) de las aplicaciones.

- Services: Un objeto que define un conjunto lógico de Pods y una política de acceso para ellos. Los Services proporcionan una dirección IP estable y un nombre DNS a tus Pods, incluso si los Pods subyacentes cambian o se escalan. Hay diferentes tipos de Services (ClusterIP, NodePort, LoadBalancer, ExternalName).

- Namespaces: Una forma de dividir un clúster de Kubernetes en entornos virtuales aislados. Permite organizar los recursos y equipos dentro de un mismo clúster (ej.

dev,staging,production). - Volumes: Permiten la persistencia de datos. Un Pod es efímero; si se reinicia, los datos dentro de sus contenedores se pierden. Los Volumes proporcionan almacenamiento persistente que puede ser montado por uno o varios contenedores.

- ConfigMaps: Se utilizan para almacenar datos de configuración no confidenciales como pares clave-valor. Permiten desacoplar la configuración de la imagen del contenedor, facilitando la gestión de diferentes configuraciones para distintos entornos.

- Secrets: Similar a ConfigMaps, pero diseñado para almacenar datos confidenciales como contraseñas, tokens de API o claves SSH. Kubernetes cifra estos secretos y los gestiona de forma segura.

Escalado Horizontal y Vertical en Kubernetes:

Kubernetes ofrece poderosas capacidades de escalado:

- Escalado Horizontal:Horizontal Pod Autoscaler (HPA): Escala automáticamente el número de Pods en un Deployment o ReplicaSet basándose en métricas de uso (ej. CPU, memoria) o métricas personalizadas.

- Cluster Autoscaler: Escala automáticamente el número de nodos de trabajo en el clúster cuando hay Pods pendientes de programar debido a la falta de recursos, o reduce los nodos cuando no son necesarios.

- Escalado Vertical (VPA):Vertical Pod Autoscaler (VPA): (Aunque menos común y más complejo en algunos escenarios) ajusta automáticamente las solicitudes y límites de CPU y memoria para los contenedores en un Pod basándose en su uso histórico.

Ecosistema de Kubernetes: Helm, Operators, etc.

El ecosistema de Kubernetes es vasto y en constante crecimiento, con herramientas que extienden sus capacidades:

- Helm: El "administrador de paquetes" para Kubernetes. Permite definir, instalar y actualizar aplicaciones complejas de Kubernetes. Un "Chart" de Helm es una colección de archivos que describen un conjunto relacionado de recursos de Kubernetes.

- Operators: Un método para empaquetar, desplegar y gestionar una aplicación de Kubernetes. Los Operators extienden la API de Kubernetes para automatizar la gestión de aplicaciones con estado (como bases de datos) de manera específica para el dominio.

- CRI (Container Runtime Interface): Una interfaz para que Kubernetes se comunique con diferentes runtimes de contenedores (como containerd, CRI-O, y por supuesto, Docker).

- CNI (Container Network Interface): Una especificación para configurar la red entre contenedores.

- CSI (Container Storage Interface): Una especificación para exponer sistemas de almacenamiento de bloques y archivos a cargas de trabajo en contenedores.

Casos de Uso y Beneficios de Kubernetes:

- Gestión de Microservicios: Facilita la implementación, escalado y gestión de cientos de microservicios.

- Aplicaciones Nativa de la Nube: La plataforma ideal para construir y ejecutar aplicaciones diseñadas para la nube, aprovechando la elasticidad y la resiliencia.

- Migración de Aplicaciones Legadas (Lift-and-Shift): Permite "contenerizar" aplicaciones existentes y desplegarlas en un entorno moderno.

- CI/CD Avanzado: Proporciona un objetivo de despliegue consistente y automatizable para pipelines de entrega continua.

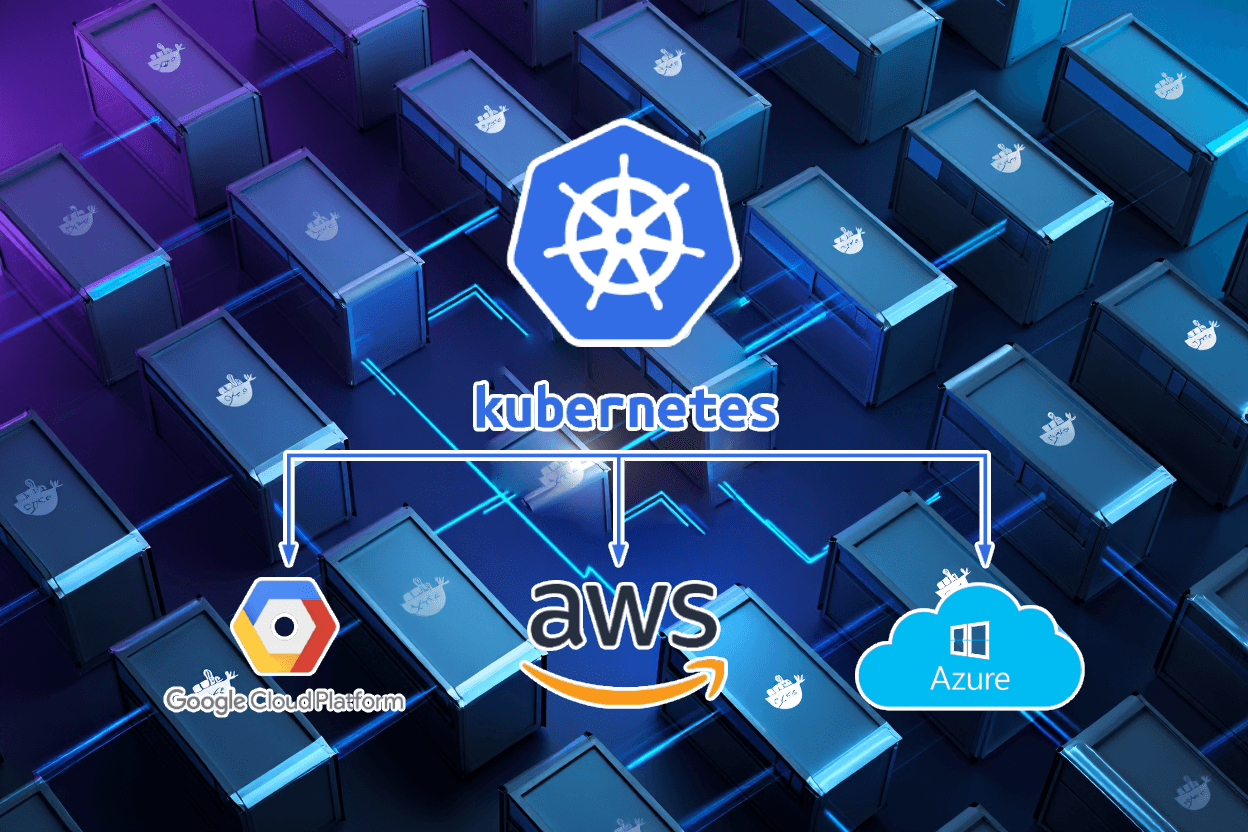

- Entornos Híbridos y Multi-Nube: Puede ejecutarse en cualquier lugar (on-premise, AWS, Azure, GCP, etc.), permitiendo arquitecturas híbridas o multi-nube.

Recursos recomendados para Kubernetes:

- Documentación oficial de Kubernetes: https://kubernetes.io/docs/home/ (La fuente definitiva de información).

- Kubernetes The Hard Way: https://github.com/kelseyhightower/kubernetes-the-hard-way (Un enfoque práctico y profundo para entender cómo funciona Kubernetes desde cero).

- Certified Kubernetes Administrator (CKA) Curriculum: https://training.linuxfoundation.org/certification/certified-kubernetes-administrator-cka/ (Si buscas una comprensión estructurada y profunda, este es un excelente recurso para el estudio).

Conclusión

Docker y Kubernetes, aunque a menudo se mencionan juntos, cumplen roles distintos pero complementarios. Docker se encarga de empaquetar y ejecutar aplicaciones de manera eficiente en contenedores, estandarizando la unidad de despliegue. Kubernetes, por otro lado, es el director de orquesta que gestiona un ejército de estos contenedores, asegurando que tus aplicaciones sean escalables, altamente disponibles y fáciles de gestionar a gran escala.

Dominar estas tecnologías no es solo una tendencia; es una habilidad fundamental para cualquier ingeniero de software o DevOps en el panorama actual de la infraestructura. Son, sin lugar a dudas, la columna vertebral sobre la cual se construyen y operan las aplicaciones modernas y distribuidas.