Balanceo de Carga: Distribuyendo el Tráfico para la Eficiencia y la Resiliencia

En el mundo de las aplicaciones web y los servicios distribuidos, la capacidad de manejar un alto volumen de tráfico de manera eficiente es tan crucial como la funcionalidad misma de la aplicación. Un sitio web lento o inaccesible puede significar la pérdida de usuarios, clientes e ingresos. Aquí es donde entra en juego una pieza fundamental de la arquitectura de red: el balanceador de carga.

En este artículo, exploraremos en profundidad el concepto de balanceo de carga, sus objetivos, los diferentes tipos y algoritmos, y nos adentraremos en tres soluciones populares: Nginx, AWS Elastic Load Balancing (ELB) y Google Cloud Platform (GCP) Load Balancer.

¿Qué es el Balanceo de Carga?

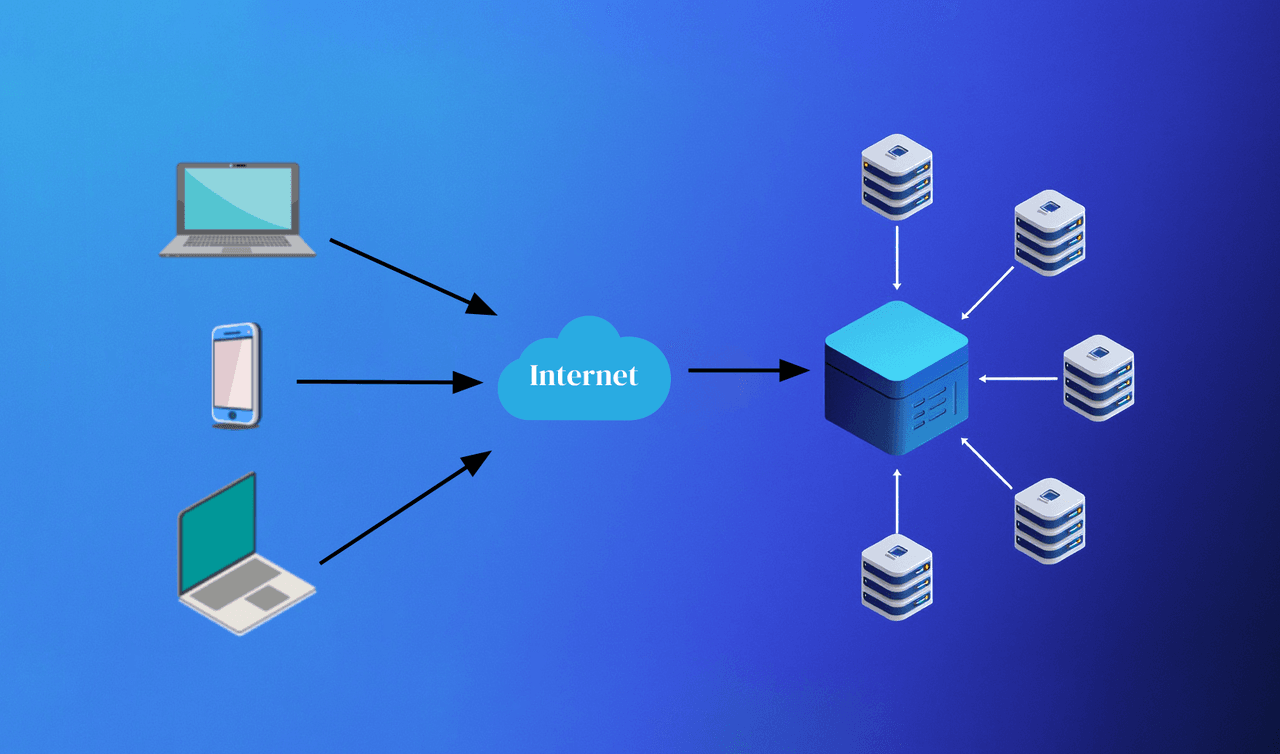

El balanceo de carga es el proceso de distribuir el tráfico de red entrante de manera equitativa entre un grupo de servidores de backend (también conocidos como pools de servidores o granjas de servidores). En lugar de enviar todas las solicitudes a un solo servidor, el balanceador de carga actúa como un "controlador de tráfico" que dirige las solicitudes a los servidores más adecuados para manejarlas.

Objetivos Clave del Balanceo de Carga:

- Distribución de Solicitudes: Su función principal es asegurar que ningún servidor individual se sobrecargue, lo que podría llevar a una degradación del rendimiento o incluso a la caída del servicio. Al distribuir la carga, se maximiza la utilización de los recursos de todos los servidores.

- Alta Disponibilidad y Tolerancia a Fallos: Si un servidor de backend falla o deja de responder, el balanceador de carga lo detecta y redirige automáticamente el tráfico a los servidores saludables restantes. Esto garantiza que la aplicación permanezca disponible para los usuarios, incluso si algunos componentes fallan.

- Reducción de Latencia: Al distribuir la carga, se reduce el tiempo de respuesta de los servidores, ya que cada uno maneja una porción manejable del tráfico. Esto se traduce en una experiencia de usuario más rápida y fluida.

- Escalabilidad: El balanceo de carga facilita la escalabilidad horizontal. Puedes añadir o quitar servidores de backend según la demanda, y el balanceador de carga ajustará automáticamente la distribución del tráfico, sin interrupción para los usuarios.

- Gestión de Sesiones (Persistencia): Para aplicaciones que requieren que un usuario permanezca conectado al mismo servidor durante una sesión (ej. carritos de compra, sesiones de inicio de sesión), los balanceadores de carga pueden mantener la "persistencia de sesión" o "afinidad de sesión" mediante el enrutamiento de solicitudes del mismo cliente al mismo servidor.

Tipos de Balanceadores de Carga: Hardware vs. Software

Los balanceadores de carga pueden clasificarse principalmente por su implementación:

Balanceadores de Carga de Hardware:

- Características: Son dispositivos físicos dedicados, optimizados para el rendimiento y la seguridad a gran escala. Suelen ser muy potentes y capaces de manejar un volumen masivo de tráfico.

- Ventajas: Alto rendimiento, baja latencia, seguridad robusta a nivel de dispositivo, funcionalidades avanzadas incorporadas.

- Desventajas: Costo inicial muy elevado, menor flexibilidad (difíciles de escalar o adaptar a cambios rápidos), complejidad de gestión.

- Casos de Uso: Grandes empresas con tráfico masivo, centros de datos propios donde se necesita un control granular del hardware. Ejemplos: F5 BIG-IP, Citrix NetScaler.

Balanceadores de Carga de Software:

- Características: Son aplicaciones de software que se ejecutan en servidores commodity (VMs o contenedores). Pueden ser autogestionados (como Nginx, HAProxy) o servicios gestionados en la nube (como AWS ELB, GCP Load Balancer).

- Ventajas: Costo significativamente menor (especialmente en la nube), gran flexibilidad y escalabilidad (fácil de añadir o quitar instancias), facilidad de integración con otros servicios en la nube, despliegues rápidos.

- Desventajas: El rendimiento puede depender de la capacidad del hardware subyacente y la optimización del software, pueden requerir más configuración y gestión si son autogestionados.

- Casos de Uso: La mayoría de las aplicaciones web y de microservicios modernas, entornos de nube, startups, empresas que buscan agilidad y optimización de costos.

Algoritmos de Balanceo de Carga: Cómo se Decide el Destino

Los balanceadores de carga utilizan diferentes algoritmos para decidir a qué servidor de backend enviar una solicitud. La elección del algoritmo depende de los requisitos específicos de la aplicación:

Round Robin (El "Turno de Uno en Uno"):

- Funcionamiento: Distribuye las solicitudes secuencialmente a cada servidor en el grupo, en un orden rotatorio.

- Ventajas: Muy simple y fácil de implementar.

- Desventajas: No considera la capacidad o la carga actual de los servidores, lo que puede llevar a que servidores más lentos o sobrecargados reciban más solicitudes.

- Ideal para: Servidores con capacidades de procesamiento similares y cargas de trabajo homogéneas.

Weighted Round Robin (Round Robin Ponderado):

- Funcionamiento: Similar a Round Robin, pero a cada servidor se le asigna un "peso". Los servidores con mayor peso reciben más solicitudes.

- Ventajas: Permite distribuir la carga de manera desigual, favoreciendo a los servidores más potentes o con más recursos.

- Ideal para: Clústeres heterogéneos con servidores de diferentes capacidades.

Least Connections (Menos Conexiones):

- Funcionamiento: Dirige el tráfico al servidor que tiene el menor número de conexiones activas en ese momento.

- Ventajas: Muy eficaz para distribuir la carga de manera inteligente, ya que considera el estado actual de los servidores.

- Desventajas: Requiere que el balanceador de carga mantenga un seguimiento del número de conexiones.

- Ideal para: Aplicaciones con conexiones de larga duración o cargas de trabajo variadas.

Least Response Time (Menor Tiempo de Respuesta):

- Funcionamiento: Envía la solicitud al servidor que tiene el menor tiempo de respuesta promedio y el menor número de conexiones activas.

- Ventajas: Combina la carga con el rendimiento, lo que puede resultar en la mejor experiencia de usuario.

- Desventajas: Es más complejo de implementar y requiere monitorización constante de los tiempos de respuesta.

IP Hash (Hash de IP):

- Funcionamiento: Utiliza un hash de la dirección IP de origen del cliente para determinar a qué servidor enviar la solicitud. Esto asegura que el mismo cliente siempre se conecte al mismo servidor.

- Ventajas: Proporciona persistencia de sesión sin necesidad de cookies o información de aplicación.

- Desventajas: Si un servidor falla, todos los clientes que estaban asociados a él se redirigirán a otro, lo que puede sobrecargar un servidor de repente.

- Source IP Affinity (Afinidad por IP de Origen): Similar a IP Hash, pero con una implementación más flexible que puede incluir rangos de IP.

Nginx: El Servidor Web y Proxy Inverso Versátil

Nginx (Engine-X) es un software de código abierto, de alto rendimiento, que funciona como servidor web, proxy inverso, proxy de correo electrónico y, lo que nos interesa aquí, balanceador de carga. Es conocido por su eficiencia, bajo consumo de recursos y capacidad para manejar un gran número de conexiones concurrentes.

¿Qué es Nginx? Servidor web y proxy inverso de alto rendimiento

Nginx es la elección preferida para muchos arquitectos y desarrolladores debido a su arquitectura asíncrona y basada en eventos, que le permite manejar eficientemente miles de conexiones a la vez, a diferencia de los servidores web tradicionales basados en procesos.

Como proxy inverso, Nginx se sitúa entre los clientes y los servidores de backend. Las solicitudes del cliente llegan a Nginx, que luego las reenvía al servidor apropiado. Esto no solo mejora la seguridad (ocultando los servidores de backend), sino que también permite funcionalidades como el balanceo de carga, la terminación SSL y el almacenamiento en caché.

Configuración Básica de Nginx como Balanceador de Carga

La configuración de Nginx como balanceador de carga es sorprendentemente sencilla y se realiza a través de su archivo de configuración (nginx.conf o archivos incluidos en conf.d).

Un ejemplo básico de balanceo de carga Round Robin para un pool de servidores web:

Para usar Weighted Round Robin, simplemente añade un peso a la directiva server:

Para Least Connections, añade la directiva least_conn al bloque upstream:

Características Avanzadas de Nginx:

- Caché: Nginx puede actuar como un servidor de caché, almacenando respuestas de solicitudes frecuentes para servirlas directamente sin tener que contactar a los servidores de backend. Esto reduce la carga y mejora el tiempo de respuesta.

- SSL Termination (Terminación SSL/TLS): Nginx puede manejar el cifrado y descifrado de las comunicaciones HTTPS, liberando a los servidores de backend de esta tarea intensiva en CPU. Esto permite que el tráfico interno a los servidores backend sea HTTP (más rápido) y que el cifrado solo se realice en el borde de la red.

- Reescritura de URLs: Permite modificar las URLs de las solicitudes entrantes antes de reenviarlas a los servidores de backend, útil para SEO o para adaptar la estructura de la aplicación.

- Servir Archivos Estáticos: Excelente rendimiento para servir imágenes, CSS, JavaScript directamente.

- Compresión (gzip): Comprime las respuestas antes de enviarlas al cliente, reduciendo el tamaño de los datos y el tiempo de carga.

- Monitoreo y Gestión de Salud: Nginx puede realizar "chequeos de salud" (health checks) periódicos a los servidores de backend para asegurarse de que estén activos y respondiendo correctamente. Si un servidor falla, lo sacará temporalmente del pool de balanceo.

Recursos recomendados para Nginx:

- Documentación oficial de Nginx: https://nginx.org/en/docs/ (La fuente autorizada para todas las configuraciones).

- Nginx como balanceador de carga (guías): https://docs.nginx.com/nginx/admin-guide/load-balancer/http-load-balancer/ (Guías detalladas sobre la configuración y las características de balanceo de carga).

AWS ELB (Elastic Load Balancing): El Balanceador de Carga Gestionado de AWS

AWS Elastic Load Balancing (ELB) es un servicio completamente gestionado que distribuye el tráfico de red entrante automáticamente a través de múltiples objetivos, como instancias de Amazon EC2, contenedores y direcciones IP. Al ser un servicio gestionado, AWS se encarga de la escalabilidad, la disponibilidad y el mantenimiento del balanceador de carga, lo que te permite centrarte en tus aplicaciones.

Tipos de ELB:

AWS ofrece diferentes tipos de balanceadores de carga para diferentes escenarios, cada uno optimizado para un tipo específico de tráfico:

- Application Load Balancer (ALB):

- Nivel: Capa 7 (HTTP/HTTPS).

- Características: Ideal para balancear la carga de solicitudes HTTP y HTTPS a nivel de aplicación. Permite el enrutamiento basado en contenido (ej. enrutar solicitudes a

/apia un grupo de servidores y solicitudes a/imagesa otro), terminación SSL/TLS, autenticación de usuarios. - Casos de Uso: Microservicios, arquitecturas basadas en contenedores (ECS, EKS), aplicaciones basadas en URL o cabeceras, balanceo de carga para APIs RESTful.

- Ventajas: Gran flexibilidad para el enrutamiento, integración con AWS WAF (Web Application Firewall).

- Network Load Balancer (NLB):

- Nivel: Capa 4 (TCP/UDP).

- Características: Diseñado para manejar un rendimiento extremadamente alto, latencia ultrabaja y la capacidad de soportar un tráfico masivo. Mantiene la dirección IP de origen del cliente.

- Casos de Uso: Juegos en línea, aplicaciones de alto rendimiento, cargas de trabajo de baja latencia, donde se necesitan direcciones IP estáticas para los clientes o la aplicación.

- Ventajas: Rendimiento excepcional, IP estática, preserva la IP de origen del cliente.

- Gateway Load Balancer (GLB):

- Nivel: Capa 3 (IP) y 4 (TCP/UDP).

- Características: Permite desplegar, escalar y gestionar fácilmente appliances virtuales de red de terceros, como firewalls, sistemas de detección de intrusiones (IDS) y pasarelas transparentes.

- Casos de Uso: Insertar dispositivos de seguridad o de inspección de tráfico en el camino de la red.

- Ventajas: Simplifica la inserción de servicios de seguridad de terceros.

- Classic Load Balancer (CLB):

- Nivel: Capa 4 (TCP) y Capa 7 (HTTP/HTTPS).

- Características: El balanceador de carga original de AWS. Aunque todavía se puede usar, AWS recomienda usar ALB o NLB para la mayoría de los casos nuevos.

- Casos de Uso: Aplicaciones heredadas que ya lo utilizan.

- Consideraciones: Menos características y flexibilidad que ALB/NLB.

Características Clave e Integración con Otros Servicios de AWS:

- Health Checks: Todos los tipos de ELB realizan chequeos de salud automatizados para monitorear el estado de las instancias registradas y redirigir el tráfico solo a los objetivos saludables.

- Integración con Auto Scaling: ELB se integra perfectamente con Amazon EC2 Auto Scaling. Los grupos de Auto Scaling pueden añadir o quitar instancias automáticamente en respuesta a la demanda, y ELB las registrará o anulará el registro sin intervención manual.

- Balanceo de Carga Multi-AZ: ELB distribuye automáticamente el tráfico a través de múltiples zonas de disponibilidad (AZs) dentro de una región, aumentando la resiliencia y la disponibilidad.

- Terminación SSL/TLS: ALB y CLB pueden manejar la terminación SSL/TLS, descargando esta tarea de los servidores de backend y permitiendo el tráfico HTTP interno.

- Sticky Sessions (Persistencia): Permiten que las solicitudes de un cliente se envíen consistentemente al mismo servidor de backend.

- Métricas y Registros: ELB proporciona métricas detalladas a través de Amazon CloudWatch y registros de acceso a través de Amazon S3, lo que facilita el monitoreo y la resolución de problemas.

Recursos recomendados para AWS ELB:

- Documentación oficial de AWS ELB: https://docs.aws.amazon.com/elasticloadbalancing/latest/userguide/what-is-elastic-load-balancing.html (La guía completa de AWS sobre ELB).

- Comparación de tipos de ELB: https://aws.amazon.com/elasticloadbalancing/features/ (Una tabla comparativa muy útil para elegir el ELB adecuado).

GCP Load Balancer: Balanceo de Carga Global en Google Cloud Platform

Google Cloud Platform (GCP) ofrece una suite de balanceadores de carga de alto rendimiento y escalables, conocidos por su capacidad de balanceo de carga global y el uso de la red global de Google. A diferencia de AWS, muchos de los balanceadores de carga de GCP son de "capa global", lo que significa que pueden balancear el tráfico a través de múltiples regiones.

Tipos de Balanceadores de Carga en GCP:

GCP clasifica sus balanceadores de carga en dos categorías principales: External Load Balancers (para tráfico de Internet a tu VPC) e Internal Load Balancers (para tráfico dentro de tu VPC).

1. External Load Balancers (Balanceadores de Carga Externos):

Global External HTTP(S) Load Balancer:

- Nivel: Capa 7 (HTTP/HTTPS).

- Características: Un balanceador de carga global, basado en proxy, que utiliza la red perimetral de Google para enrutar el tráfico a las instancias más cercanas al usuario, optimizando la latencia. Permite enrutamiento basado en URL, terminación SSL, Cloud CDN (Content Delivery Network) y Google Cloud Armor (WAF).

- Casos de Uso: Aplicaciones web globales, microservicios, APIs.

- Ventajas: Balanceo de carga entre regiones, optimización de latencia, integración con Cloud CDN y Cloud Armor.

- Global External TCP Proxy Load Balancer:

- Nivel: Capa 4 (TCP).

- Características: Un balanceador de carga global basado en proxy para tráfico TCP que no es HTTP(S). Termina la conexión TCP del cliente en el borde de la red de Google y crea una nueva conexión a la instancia de backend.

- Casos de Uso: Tráfico TCP para aplicaciones que no son web, como juegos, aplicaciones móviles.

Global External SSL Proxy Load Balancer:

- Nivel: Capa 4 (SSL).

- Características: Similar al TCP Proxy, pero para tráfico SSL/TLS (no HTTPS). Termina la conexión SSL del cliente en el borde de la red de Google y crea una nueva conexión a la instancia de backend.

- Casos de Uso: Aplicaciones heredadas que usan SSL directamente sobre TCP.

- External Passthrough Network Load Balancer (antes conocido como External TCP/UDP Load Balancer):

- Nivel: Capa 4 (TCP/UDP).

- Características: Un balanceador de carga regional (no global), de paso, que no es proxy. Preserva la dirección IP de origen del cliente y no termina la conexión en el balanceador.

- Casos de Uso: Aplicaciones que requieren la IP de origen del cliente, alto rendimiento para juegos o VoIP, tráfico UDP.

2. Internal Load Balancers (Balanceadores de Carga Internos):

Internal HTTP(S) Load Balancer:

- Nivel: Capa 7 (HTTP/HTTPS).

- Características: Permite balancear la carga de tráfico interno dentro de tu Virtual Private Cloud (VPC) entre servicios de microservicios. Es un balanceador de carga regional.

- Casos de Uso: Microservicios internos, balanceo de carga entre capas de una aplicación multi-tier.

Internal Passthrough Network Load Balancer (antes conocido como Internal TCP/UDP Load Balancer):

- Nivel: Capa 4 (TCP/UDP).

- Características: Permite balancear la carga de tráfico TCP/UDP interno a través de una IP privada, manteniendo la IP de origen.

- Casos de Uso: Base de datos interna, servicios internos que requieren balanceo de carga L4.

Características Clave del Balanceo de Carga en GCP:

- Balanceo de Carga Global y Anycast IP: La mayoría de los balanceadores de carga externos de GCP ofrecen una IP Anycast. Esto significa que los usuarios de todo el mundo se conectan a la misma dirección IP, pero el tráfico se enruta automáticamente al punto de presencia de Google más cercano al usuario y luego a la región de backend más cercana y saludable. Esto minimiza la latencia global.

- Escalabilidad Automática: Los balanceadores de carga de GCP se escalan automáticamente para manejar cualquier volumen de tráfico.

- Integración con Servicios de GCP: Integración profunda con Cloud CDN (para almacenamiento en caché de contenido estático), Cloud Armor (seguridad de borde), Managed Instance Groups (para autoescalado de instancias VM), Google Kubernetes Engine (GKE) y otros servicios.

- Monitoreo y Logging: Se integran con Cloud Monitoring y Cloud Logging para proporcionar visibilidad completa sobre el tráfico y el rendimiento.

- Terminación SSL/TLS: En los balanceadores de carga basados en proxy (HTTP(S), TCP Proxy, SSL Proxy), GCP puede manejar la terminación SSL/TLS en el borde de su red, reduciendo la carga en tus backends.

Recursos recomendados para GCP Load Balancer:

- Documentación oficial de GCP Load Balancing: https://cloud.google.com/load-balancing/docs/overview (La guía completa de los balanceadores de carga de Google Cloud).

- Guía de tipos de balanceadores de carga en GCP: https://cloud.google.com/load-balancing/docs/choosing-a-load-balancer (Ayuda a decidir qué balanceador de carga es el adecuado para tu caso de uso).

El balanceo de carga es mucho más que simplemente distribuir el tráfico. Es una estrategia fundamental para garantizar la alta disponibilidad, la escalabilidad y el rendimiento de tus aplicaciones. Ya sea que optes por una solución de código abierto como Nginx para tener un control más granular, o por servicios gestionados en la nube como AWS ELB o GCP Load Balancer para simplificar la operación y aprovechar las infraestructuras globales, comprender cómo funcionan y cómo utilizarlos es clave para construir sistemas robustos y resilientes en el panorama tecnológico actual. Al elegir el balanceador de carga y el algoritmo adecuados, puedes optimizar la experiencia de usuario y la eficiencia de tu infraestructura.